Bereit für ein neues Zeitalter

Lange besteht bereits die Möglichkeit, Artificial Intelligence (AI) unternehmensseitig zu nutzen. In der heutigen Zeit wird diese Option mehr und mehr zur Notwendigkeit. Doch was genau ist AI, wie können Unternehmen diese nutzen und wo ist das überhaupt sinnvoll? Antworten gibt Dario Luipers vom Mittelstand-Digital Zentrum Rheinland in diesem Gastbeitrag.

Durch die neuesten Errungenschaften in der AI-Forschung und -Entwicklung stehen einige AI-Tools zur Verfügung, die jederzeit in den Arbeitsalltag eingebunden werden können. AI-basierte Sprachanwendungen, die auf sogenannten Large Language Models (LLM) gründen, erzeugen automatisch Texte auf Basis von Fragen oder Stichpunkten, kürzen sie oder formulieren den Inhalt in gewünschtem Sprachstil. Selbst für die Erstberatung von Kunden können AI-generierte Texte eingesetzt werden. Aktuelles Beispiel hierfür ist <a href="https://www.taod.de/tech-beratung/chatgpt“ data-webtrackingID="blog_content_link" > ChatGPT </a>, das viele Unternehmen derzeit als professionelles Textkreations-Tool implementieren. AI-basierte Bildanwendungen, wie beispielsweise Stable Difusion, dienen zur Herstellung von neuem Bildmaterial. Unternehmen setzen solche visuellen Neuerungen gerne für Werbezwecke oder die Erstellung von Präsentationen ein.

Aus Sicht der Wertschöpfung sind datengetriebene Analysen und Prozessunterstützung die weitaus sinnvolleren Anwendungsbereiche für AI, vor allem im Produktionsbereich. Hierfür werden natürlich Daten benötigt, mit denen Machine-Learning-Algorithmen angelernt werden, Muster in den Datenstrukturen zu erkennen. Was allgemein als AI bezeichnet wird, sind meist sogenannte Deep-Learning-Modelle oder Deep Neuronal Networks, die nach dem Vorbild der Neuronenverknüpfungen in Gehirnen konstruiert wurden. Teilweise können aber auch simplere Algorithmen, wie zum Beispiel eine Lineare Regression, verwendet werden. Das Ziel dieser Algorithmen bestimmt das Anwendungsgebiet.

Machine-Learning-Modelle trainieren

Hierbei kann zwischen Regressionen, Klassifizierungen und Clusterbildung unterschieden werden. Regressionen oder Voraussagen lassen sich auf unterschiedliche Szenarien anwenden. Dazu gehört unter anderem die vorausschauende Instandhaltung, die Ausfallzeitpunkte von Maschinen prognostizieren kann, oder im Fall der Predictive Quality die Produktqualität des zu produzierenden Bauteils. Klassifizierung findet verstärkt Anwendung in der automatischen Inspektion von Bauteilen über Machine-Vision-Algorithmen. Im Falle der Clusterbildung versucht der Algorithmus, Datenkategorien zu bilden. Somit können zum Beispiel Kombinationen von Maschinenparametern ermittelt werden, die zu einem erhöhten Ausschuss führen. All diese Anwendungen brauchen gut trainierte Machine-Learning-Modelle. „Gut“ heißt in diesem Fall, dass die Aussagen, beziehungsweise die aus den Eingabedaten ermittelten Rückschlüsse, stimmig sind. Um dies zu erreichen, gibt es zwei Kriterien:

Datenquantität und Datenqualität

Die Datenquantität zum Anlernen von AI sollte möglichst hoch sein. Je mehr, desto besser lautet hier die Devise. Je höher die Variation der Datengrundlage ist, desto mehr unterschiedliche Beispiele stehen dem Algorithmus zur Verfügung, um von diesen zu lernen. Wichtig ist, dass keine veralteten Daten genutzt werden, die eventuell nicht mehr den aktuellen Stand des Prozesses wiedergeben. Dieser Aspekt schließt direkt an das Thema Datenqualität an. Die Daten, anhand derer der Algorithmus lernt, sollten möglichst „clean“ sein. Das bedeutet, dass es in der Datenaufzeichnung keine Lücken durch beispielsweise ausgefallene Sensoren gab. Die Daten dürfen nicht zu “verrauscht” sein. Hier ist die Standardabweichung ein guter Indikator, sie sollte nicht zu hoch sein. Ausreißer aus den Trainingsdaten werden am besten entfernt. Nicht skalare Werte sollten einheitlich definiert sein. Dies ist zum Beispiel bei der Bewertung von der Produktgüte der Fall.

Standardisiertes Vorgehen

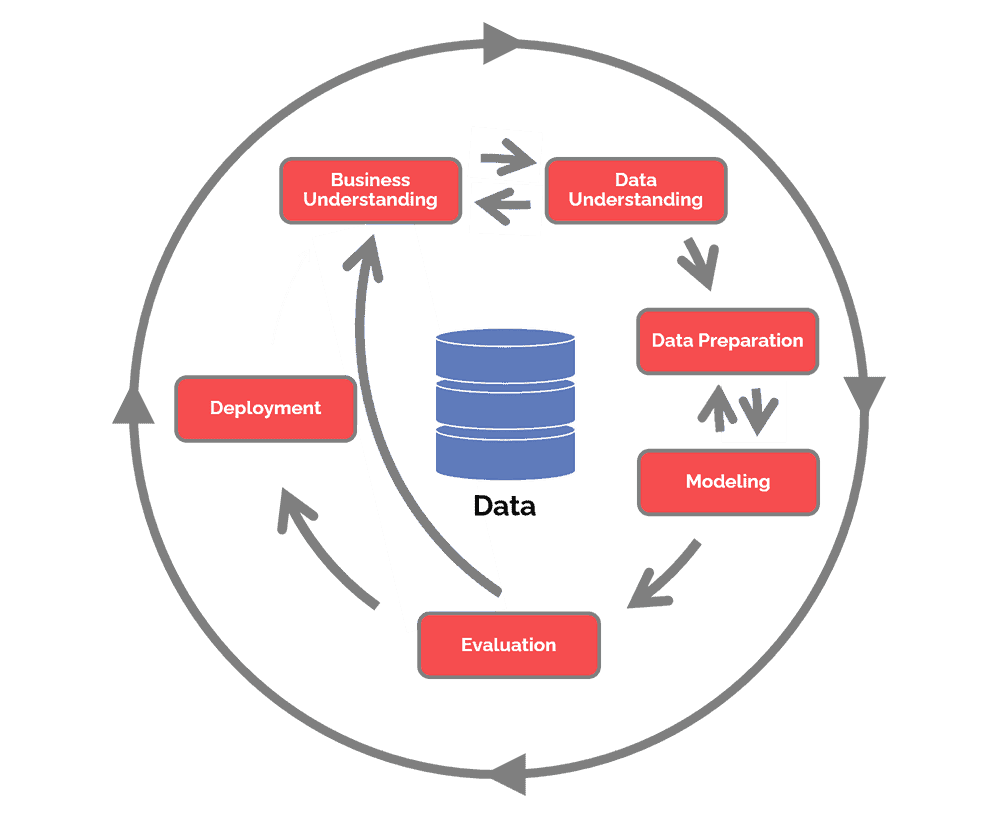

Stimmen alle diese Parameter, sollte auf diesen Daten ein Machine- oder Deep-Learning-Algorithmus trainierbar sein. Dabei lohnt es sich für das Unternehmen, methodisch vorzugehen, um <a href="https://www.taod.de/services/artificial-intelligence-consulting“ data-webtrackingID="blog_content_link" > AI wirklich gezielt einzusetzen </a>. AI-Modelle können an dieser Stelle helfen, denn sie geben Konzepte zur <a href="https://www.taod.de/services/artificial-intelligence-consulting“ data-webtrackingID="blog_content_link" > zielgerichteten Implementierung von AI </a> im Unternehmen vor. Empfehlenswert ist das sogenannte CRISP-DM (CRoss Industry Standard Process for Data Mining), ein standardisiertes Vorgehensmodell für Data Mining Projekte. Mit CRISP-DM lassen sich die einzelnen Arbeitsschritte genau definieren. Im Folgenden finden sich die wesentlichen Phasen zusammengefasst.

Business Understanding

AI dient nicht dem Selbstzweck, sondern muss vor ihrem Einsatz auf den entsprechenden Use Case geprüft werden.

Data Preparation

Dieser Schritt sorgt für die Datenquantität und -qualität. Er benötigt die meiste Arbeitskapazität und bildet die Grundlage für ein funktionierendes AI-Modell.

Evaluation

Nachdem das AI-Modell trainiert wurde, müssen die Ergebnisse des Modells genaustens untersucht werden. Gibt das Modell nicht die erwarteten Ergebnisse wieder? Woran kann dies liegen? Durch die Beantwortung dieser Frage können wichtige Erkenntnisse über den Prozess gewonnen werden, der durch die AI unterstützt werden soll.

Deployment

Wenn die vorherigen Schritte erfolgreich waren, gilt es, das AI-Modell in den Einsatz zu bringen. Wichtig ist, diesen Prozess durch eine leicht verständliche und prägnante Dokumentation festzuhalten. Hierzu gehört auch der ab sofort geltende neue und AI-gestützte Prozess. Dieser muss gewartet und gelebt werden.

Menschen und Prozesse

Ab dem Zeitpunkt des Deployments gilt es, den Prozess zu pflegen und zu warten. Der Algorithmus muss nun kontinuierlich mit Daten versorgt werden. Hierfür sollte eine entsprechende Daten-Pipeline implementiert werden. Diese stellt sicher, dass der Algorithmus in Echtzeit Daten, zum Beispiel von einer Maschine, erhält, um Prognosen über die Produktqualität oder den Wartungszeitpunkt treffen zu können. Genau wie beim Training der AI müssen die Daten eine hohe Qualität haben. Fehlerhafte Werte oder Störungen im Prozess der Datenerfassung machen den teuer implementierten Algorithmus unbrauchbar. Das AI-System muss regelmäßig mit neuen Daten nachtrainiert werden. Schwankungen im Prozess werden sonst irgendwann nicht mehr richtig vom Algorithmus gedeutet. Die Ergebnisse der AI sollten regelmäßig evaluiert werden, um Probleme im Prozess frühzeitig zu erkennen.

Nicht zu vergessen ist zudem der Faktor Mensch. Prozesse werden schlussendlich immer noch von Menschen umgesetzt und gelebt. Deshalb ist es wichtig, die Verantwortlichen für <a href="https://www.taod.de/services/artificial-intelligence-consulting“ data-webtrackingID="blog_content_link" > AI-Projekte </a> und die Mitarbeitenden vor Ort früh zusammenzubringen und alle Interessen und Aspekte, die den durch AI zu optimierenden Prozess betreffen, zu beachten.

In einem umgesetzten Projekt, an dem der Autor dieses Artikels beteiligt war, ging es darum, die Lackierung eines Bauteils mithilfe einer AI-gestützten Bilderkennung zu überwachen. Fehlerhaft lackierte Stellen sollten identifiziert und somit Nacharbeiten oder Ausschuss automatisch erkannt werden. Die skizzierten Schritte wurden alle sorgfältig umgesetzt. Kurze Zeit nach der Implementierung wurde jedes Bauteil als Ausschuss markiert. Grund hierfür war die Positionsänderung der installierten Kamera zur Datenaufnahme. Mitarbeitende fühlten sich durch diese bei ihrer Arbeit beobachtet, auch wenn der Aufgabenbereich nicht direkt mit der Qualitätskontrolle im Lackierbereich zusammenhing und das Kamerasystem keinen Arbeitsbereich von Menschen filmte.

AI und Kommunikation

Diese Erfahrung zeigt, wie wichtig eine frühe Kommunikation in AI-Projekten ist. Das Ziel, sowie die tangierten Arbeitsbereiche und Prozesse, müssen im besten Fall mit der gesamten Belegschaft kommuniziert werden. Ängste, wie zum Beispiel vor dem Verlust des Arbeitsplatzes, müssen ernst genommen und diskutiert werden. Meist sind diese unbegründet oder aber das Unternehmen ist generell gefährdet, weil es das Thema AI, sowie Datengenerierung und -verwertung (AI-Readiness) nicht genügend priorisiert.

AI wird Bestandteil in jedem Unternehmen werden müssen. Um AI wirklich effektiv einsetzen zu können, sind Daten der Grundbaustein, die eine hohe Quantität und Qualität aufweisen. Zudem muss eine Infrastruktur vorhanden sein, um Daten während des laufenden Betriebs in Echtzeit aufnehmen zu können und zu speichern. Ab diesem Zeitpunkt kann auch ganz ohne AI, rein durch <a href="https://www.taod.de/services/bi-und-data-analytics-consulting“ data-webtrackingID="blog_content_link" > Analysen </a>, meist ein enormer Mehrwert für Unternehmen entstehen. All dies ist oft nicht ohne externe Hilfe möglich. Neben vielen Dienstleistern auf dem Markt gibt es auch anbieterneutrale und kostenlose Erstunterstützung durch geförderte Projekte. Eins davon ist das Mittelstand-Digital Zentrum, das durch die Förderung vom Bundesministerium für Wirtschaft und Klimaschutz im Bereich AI erste Hilfsangebote liefert.

Dieser Artikel erschien erstmalig in abgewandelter Form in der Ausgabe 02/23 unseres Magazins data! Alle Ausgaben und Artikel findest du hier:

data! Magazin: Cloud Services, Data Analytics & AI | taod

Du möchtest AI in deinem Unternehmen einsetzen?

Über Dario Luipers

Dario Luipers leitet das Mittelstand-Digital Zentrum Rheinland und beschäftigt sich seit seinem Studium mit Künstlicher Intelligenz und Big-Data-Themen.

.webp)

%20(1).webp)